Каковы лучшие альтернативы Crawl4AI с открытым исходным кодом?

Crawl4AI — это бесплатный инструмент, который упрощает сканирование веб-страниц и извлечение данных, особенно для больших языковых моделей (LLM) и приложений искусственного интеллекта. Однако это не единственное приложение в категории. В этом посте будут обсуждаться некоторые из лучших альтернатив Crawl4AI с открытым исходным кодом.

Лучшие альтернативы Crawl4AI с открытым исходным кодом

Ниже приведены некоторые из лучших альтернатив Crawl4AI с открытым исходным кодом.

- лоскутный

- Колли

- PySpider

- X-Crawl

- Огненное ползание.

1) Скряпичный

Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)

Scrapy — это платформа с открытым исходным кодом на основе Python для сканирования и парсинга веб-страниц. Это поможет вам быстро и легко извлекать данные с веб-сайтов. Он использует Twisted, асинхронную сетевую структуру, которая позволяет ему быть чрезвычайно эффективным и быстрым.

Scrapy позволяет добавлять конвейеры и промежуточное программное обеспечение для обработки ваших данных по мере необходимости. Это упрощает добавление Scrapy в существующую среду, поскольку он поддерживает обработку запросов, переход по ссылкам и извлечение данных с помощью селекторов CSS и XPath.

Он также предоставляет интерфейс, который упрощает отслеживание данных и их извлечение с веб-сайтов. Вы также можете использовать их большое сообщество и широко доступные документы.

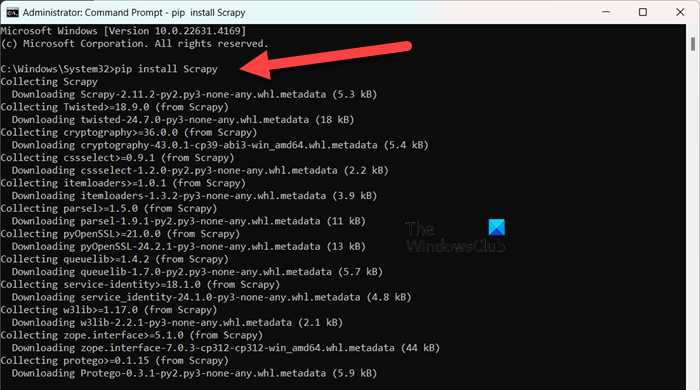

Если вы хотите установить Scrapy, вам понадобится Python 3.8+, либо реализация CPython (по умолчанию), либо реализация PyPy. После этого, если вы используете Anaconda или Miniconda, вы можете установить пакет с канала conda-forge, на котором есть актуальные пакеты для Linux, Windows и macOS, выполнив следующую команду.

установка conda -c conda-forge Scrapy

Если вы хотите установить Scrapy с помощью PyPI, выполните следующую команду в режиме командной строки с повышенными привилегиями.

pip установить Scrapy

Чтобы узнать больше об этом инструменте, посетите Scrapy.org.

2) Колли

Colly — это удобная библиотека парсинга для Golang. Он упрощает выполнение HTTP-запросов, анализ HTML-документов и извлечение данных с веб-сайтов. Colly предоставляет функции, которые помогают разработчикам перемещаться по веб-страницам, выбирать и фильтровать элементы с помощью селекторов CSS, а также выполнять различные задачи по извлечению данных.

MSP для Colly – это его высокая производительность. Он может обрабатывать более 1000 транзакций в секунду на одном ядре, а как только вы добавите больше ядер, это совсем другая история. Этого удалось добиться за счет добавления встроенной поддержки кэширования и поддержки синхронного и асинхронного очистки.

Единственные две вещи, которых не хватает Colly, — это рендеринг на JavaScript (он имеет ограниченную языковую поддержку, что для некоторых может стать препятствием, но, поскольку я использую Python, это меня не особо беспокоит) и отсутствие большого сообщества. это означает ограниченный выбор расширений, плагинов и документации.

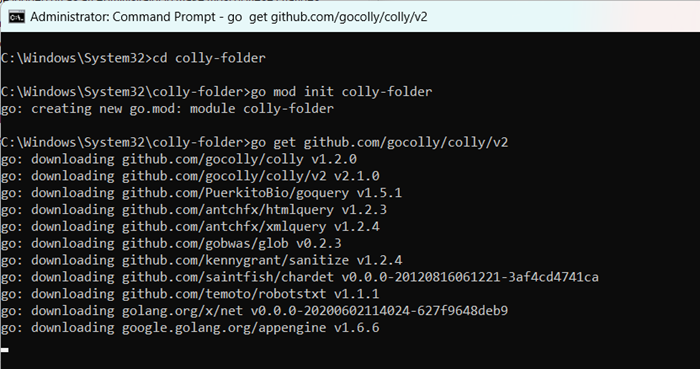

Чтобы установить Colly, нам сначала нужно установить Goland. Для этого перейдите в go.dev и установите утилиту. После этого перезагрузите компьютер, откройте Командная строка от имени администратора и выполните следующие команды.

mkdir Colly-foldercd Colly-folder Go Mod init Colly-folder Go Get github.com/gocolly/colly/v2

Вы можете заменить имя папки colly-folder на любое имя по вашему выбору. После сборки модуля вы можете запустить веб-скрапер командой — go run main.go.

Читайте: Лучшее бесплатное программное обеспечение для конвертации видео с открытым исходным кодом.

3) ПиПаук

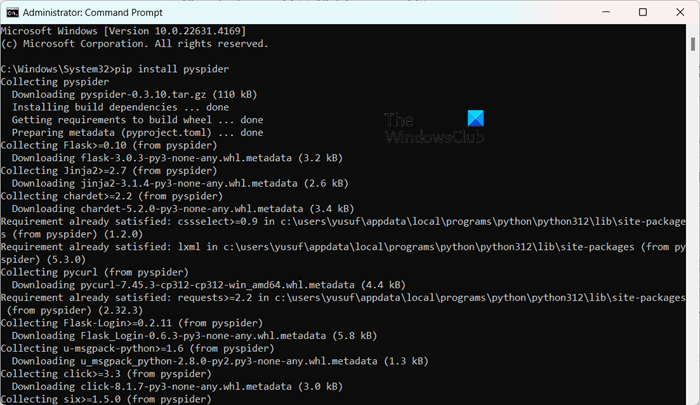

PySpider — это универсальная система веб-сканирования с веб-интерфейсом, который упрощает управление и мониторинг ваших сканеров. Он также предоставляет веб-интерфейс для задач очистки веб-страниц.

В отличие от Colly, PySpider может обрабатывать веб-сайты, на которых доминирует JavaScript, использующие PhatnomJS. Он также имеет значительно больше встроенных функций управления задачами, включая планирование задач и определение приоритетов, чем Crawl4AI. Однако производительность снижается по сравнению с Crawl4AI, поскольку последний предлагает асинхронную архитектуру.

Установить PySpider очень просто. Если в вашей системе установлен Python, просто запустите — pip install pyspider в повышенном режиме командной строки. Это автоматически установит PySpider. Чтобы запустить его, вы можете просто запустить pyspider, а затем перейти в в веб-браузере, чтобы увидеть интерфейс.

4) X-Crawl

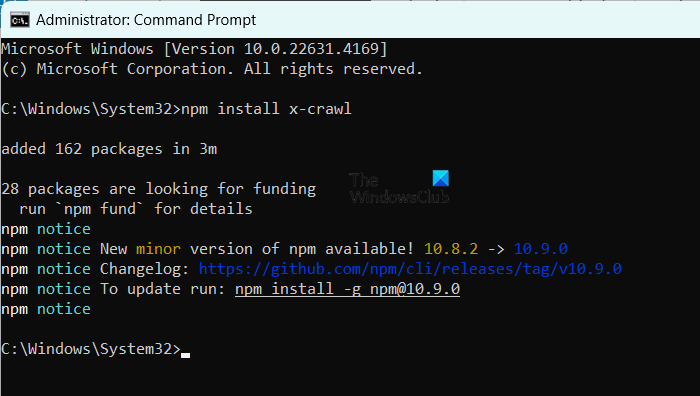

X-Crawl — это универсальная библиотека для Node.js, которая использует искусственный интеллект для сканирования веб-страниц. Это делает сканирование веб-страниц более эффективным и удобным за счет гибкого использования и мощной помощи искусственного интеллекта. Библиотека ориентирована на интеграцию возможностей искусственного интеллекта и обеспечивает надежную основу для создания веб-сканеров и парсеров.

X-Crawl может обрабатывать динамический контент, генерируемый JavaScript, который необходим для современных веб-сайтов. Он также предлагает множество функций настройки, позволяющих настроить процесс сканирования так, чтобы он работал на вас.

Между Crawl4AI и X-Crawl есть некоторые существенные различия; однако в конечном итоге это зависит от языка, которым вам удобно пользоваться. Crawl4AI использует Python, а X-Crawl — решение на основе Node-js.

Если на вашем компьютере установлен Node.js, запустите npm install x-crawl, чтобы установить его на свой компьютер.

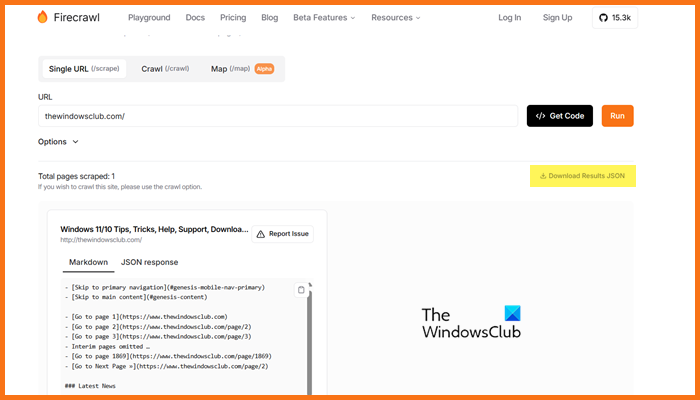

5) Огненное ползание

Firecrawl — это продвинутый инструмент сканирования веб-страниц, созданный Mendable.ai. Он предназначен для преобразования веб-контента в хорошо организованные, структурированные уценки или другие форматы, подходящие для больших языковых моделей (LLM) и приложений искусственного интеллекта. Он предоставляет готовые результаты для LLM, что позволяет легко интегрировать контент в различные языковые модели и приложения искусственного интеллекта. Вам также предоставляется простой API для отправки заданий сканирования и получения результатов. Если вы хотите попробовать Firecrawl, вы можете пойти firecrawl.devвведите URL-адрес своего веб-сайта и нажмите «Выполнить».

Какая веб-разработка с открытым исходным кодом лучшая?

Вы можете использовать различные инструменты веб-разработки с открытым исходным кодом. Вы можете использовать Visual Studio Code и Atom, если вам нужны редакторы кода.. Если вам нужны некоторые Frontend-фреймворки с открытым исходным кодом, используйте Bootstrap и Vue.jsа для бэкэнда используйте Джанго и Экспресс.js. Другие инструменты, такие как Git, GitHub, Figma, GIMP, Slack и Trello, имеют открытый исходный код, и вы можете включить их в свою среду веб-разработки.

Читайте: Каковы лучшие AI SDK для разработчиков программного обеспечения Windows?

Существуют ли модели GPT с открытым исходным кодом?

Существует множество моделей GPT с открытым исходным кодом, например GPT-Нео от ЭлеутерАИ, Церебра-GPT, БЛУМ, GPT-2 OpenAI и Мегатрон-Тьюринг НЛГ от NVIDIA и Microsoft. Эти модели предлагают различные варианты в зависимости от ваших потребностей: от языковых моделей общего назначения до моделей, предназначенных для многоязычных задач или высокопроизводительных приложений.

Читайте также: Лучшее бесплатное программное обеспечение для искусственного интеллекта для Windows.

Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)